Word embeddings

Aus exmediawiki

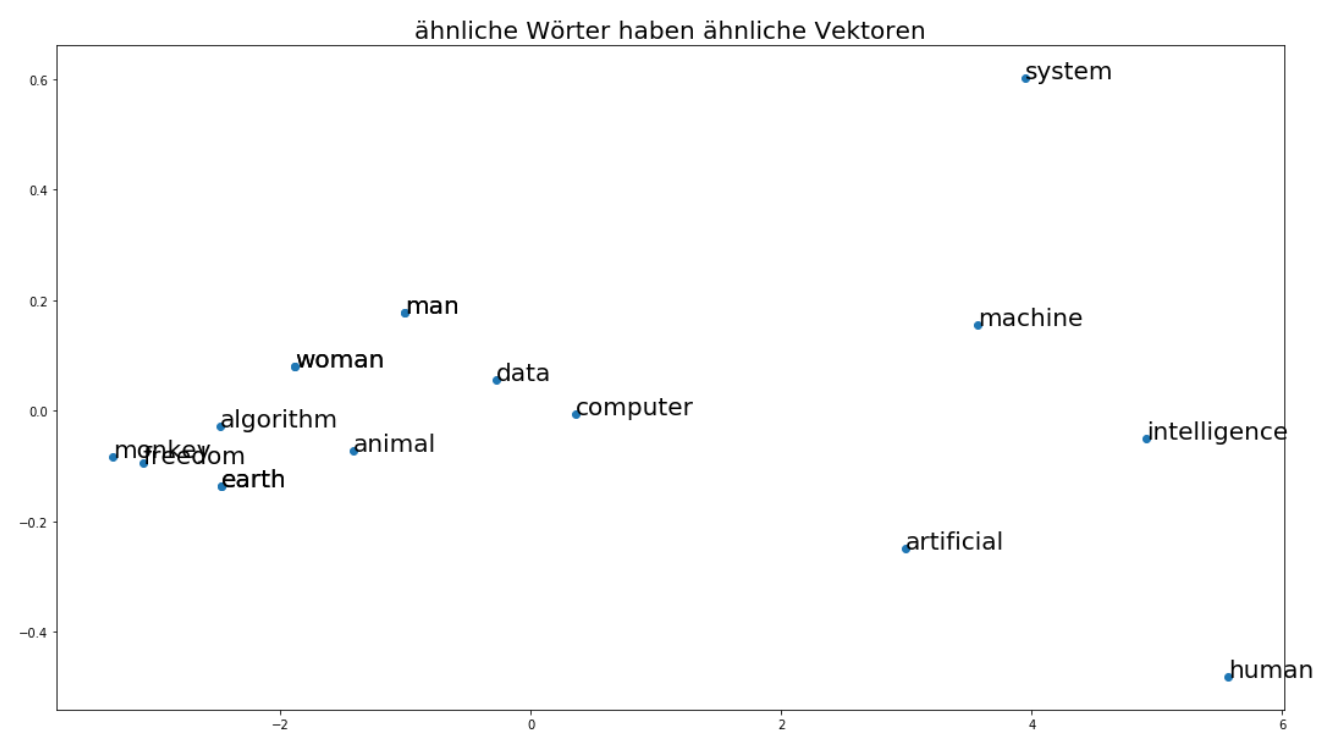

Der Sammelbegriff für eine Reihe von Sprachmodellierungs- und Feature-Learning-Techniken in der natürlichen Sprachverarbeitung (NLP), bei denen Wörter oder Phrasen aus dem Vokabular auf Vektoren mit reellen Zahlen abgebildet werden:

- ein Vektor, der die Struktur des Wortes in Bezug auf Morphologie widerspiegelt ( Anreichern von Wortvektoren mit Unterwortinformationen ) * eine Wortkontextdarstellung ( word2vec Parameter Learning Explained )

- eine globale Korpusstatistik ( GloVe: Globale Vektoren für Wortdarstellung )

- eine Worthierarchie in Bezug auf die WordNet-Terminologie ( Poincaré-Einbettungen für das Lernen hierarchischer Darstellungen )

- eine Beziehung zwischen einer Reihe von Dokumenten und den Begriffen, die sie enthalten ( latente semantische Indizierung )

- usw. ...

Warum brauchen wir embeddings?

für "meaningful" (Bedutungs-) Repräesentationen eines Wortes in einem Vectorenraum << word vectors

generell gilt, je mehr Dimensionen ein Vektor besitzt, desto mehr Bedeutung können wir in diesen hineinlegen < problem computational grenze

Inhaltsverzeichnis

Traditionelle Worteinbettungen

Bag of Words (BOW)

Ist ein sehr einfache Methode einen Text zu Vektorisieren.

Jedoch werden keine Information über den Kontex der Wörter behalten.

- Die Reihenfolge der Wörter bleibt in der Vektordarstellung nicht erhalten.

Beispiel: Die folgenden Sätze werden folgendermaßen dargestellt werden.

“Das ist ein Stift und ein Blatt Papier.” → (1 1 2 1 1 1 1 0 0 0)

“Das ist ein Hund und keine Katze.” → (1 1 1 0 1 0 0 1 1 1)

Es ist direkt zu erkennen, dass aus dem Vektor die Bedeutung des zweiten Satzes nicht mehr eindeutig ist.

term frequency–inverse document frequency (TFIDF)

Ein Problem mit dem Bag of Words-Ansatz ist, dass sehr häufige Wörter beginnen, im Dokument zu dominieren (z.B. größere Punktzahl), aber möglicherweise nicht so viel "Informationsgehalt" enthalten. Außerdem wird es längeren Dokumenten mehr Gewicht verleihen als kürzeren Dokumenten.

Ein Ansatz besteht darin, die Häufigkeit der Wörter danach zu skalieren, wie oft sie in allen Dokumenten vorkommen, so dass die Ergebnisse für häufige Wörter wie "die", die auch in allen Dokumenten häufig vorkommen, bestraft werden. Dieser Ansatz zur Bewertung wird als Term Frequency-Inverse Document Frequency, kurz TF-IDF, bezeichnet:

Term Frequency: ist eine Bewertung der Häufigkeit des Wortes im aktuellen Dokument:

TF = (Anzahl der Erscheinungen von Begriff t in einem Dokument)/(Anzahl der Begriffe im Dokument)

Inverse Document Frequency: ist eine Bewertung, wie selten das Wort in allen Dokumenten ist:

IDF = 1+log(N/n), wobei N die Anzahl der Dokumente und n die Anzahl der Dokumente ist, in denen ein Begriff t erschienen ist.

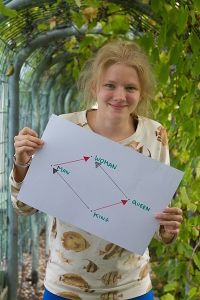

Neuronale Einbettungen / pretrained word embeddings

Word2Vec-Algorithmus

Der beliebteste Algorithmus für die Berechnung von Einbettungen. Er besteht im Wesentlichen aus einem mini neuronalen Netzwerk, das versucht, ein Sprachmodell zu lernen.

Mikolov et al., 2013: Efficient Estimation of Word Representations in Vector Space

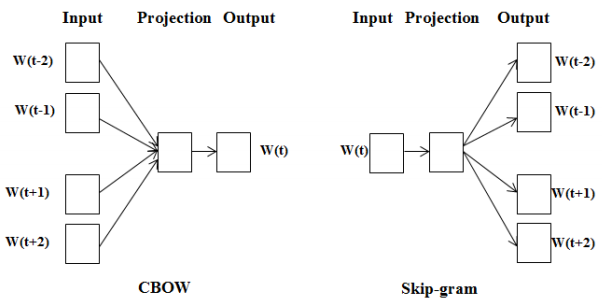

CBOW & Skip-Gram

Continuous Bag-Of-Words (CBOW)

Hier geht es darum, ein Netzwerk zu schaffen, das versucht, das Wort in der Mitte bei einigen umgebenden Wörtern vorherzusagen:

[W[-3], W[-2], W[-1], W[1], W[2], W[3]] => W[0]

Skip-Gram

Skip-Gram ist das Gegenteil von CBOW, es versucht, die umgebenden Wörter vorherzusagen, die das Wort in der Mitte enthält:

W[0] =>[W[-3], W[-2], W[-1], W[1], W[2], W[3]]]

Die berechneten Netzwerkgewichte sind eigentlich die Wort Embeddings

Word2Vec mit Gensim

Wir benutzen in unserem Seminar Gensim. Diese Bibliothek beinhaltet u.a. eine Implementation des Word2Vec Models

GloVe

Word2vec und GloVe sind Embeddings welche durch neuronale Netze erstellt werden. Word2vec wird im Gegensatz zu GloVe supervised trainiert. Außerdem arbeitet es nicht wie Word2vec direkt mit dem Text,sondern mit einer Co-Occurence Matrix über die der Kontext der Wörter erhalten bleibt.

Pennington et al., 2014: Glove: Global Vectors for Word Representation

FastText

FastText ist im Gegensatz zu word2vec kein Word-Embedding mehr, sondern ein Charachter-Embedding. Somit kann es im Gegensatz zu den word2vec und GloVe Wörter vektorisieren, welche nicht im Trainingsvokabular enthalten waren.

Joulin et al., 2016: Bag of Tricks for Efficient Text Classification

Neuronale NLP Architekturen

nächste Woche

Deep Feed Forward Network

1D CNN

RNN/LSTM

ELMo & BERT

pitfalls of modern state of the art NLP systems...

Obwohl neuronales NLP zu vielen Durchbrüchen geführt hat, wie in den vorherigen Beiträgen zu sehen, gibt es immer noch viele Mängel, die von Modellen auf dem neuesten Stand der Technik mit vorab trainierten Worteinbettungen und Aufmerksamkeitsmechanismen gezeigt wurden. Diese Fehler in der neuronalen NLP haben gefährliche Auswirkungen auf Produktionssysteme, die nur wenig oder gar keinen Spielraum für Ungenauigkeit und Unvorhersehbarkeit bieten.

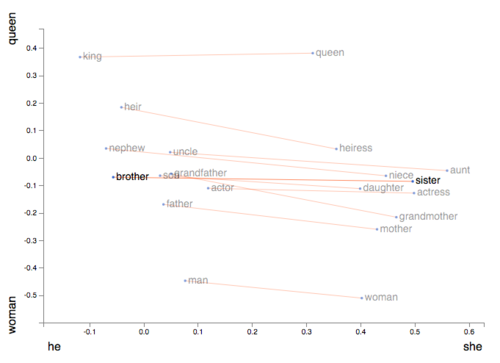

Oberflächliche Korrelationen

Eine große Herausforderung bei aktuellen Modellen besteht darin, dass sie oberflächliche Korrelationen in Daten lernen, die zu Modellen führen, die implizite soziale Vorurteile erfassen.

1. Elazar and Goldberg et. al haben frühe Versuche gemacht mit adversarial training dem System immanente biases zu beseitigen: https://github.com/yanaiela/demog-text-removal

2. weiteres Jupyter-Notebook: How to make a racist AI without really trying

kontroverse Bewertung

Ein Nebenprodukt der oberflächlichen Korrelationen ist, dass sie Modelle einem gegnerischen Angriff aussetzen.

Die Auswirkungen sind ziemlich schockierend, da man sich vorstellen kann, widersprüchliche Beispiele zu verwenden, um kritische Produktions-NLP-Systeme in Branchen wie dem digitalen Gesundheitswesen, der digitalen Versicherung und dem digitalen Recht zu manipulieren und auszunutzen.

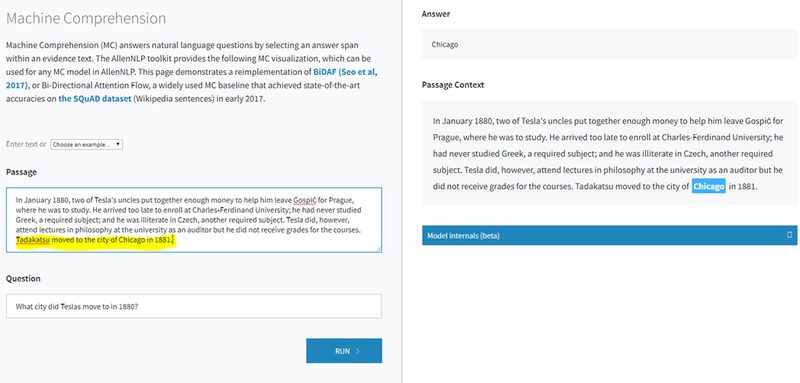

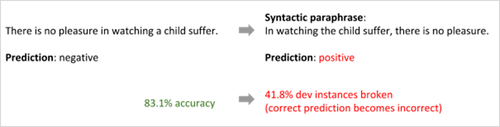

Semantische Variabilität

In der natürlichen Sprache gibt es viele Arten oder Umschreibungen, die dasselbe Konzept, dieselbe Beziehung oder dieselbe Idee ausdrücken können.

Ein möglicher Indikator dafür, dass oberflächliche Korrelationen viele Ergebnisse des Standes der Technik beeinflussen, ist, dass das Modell, obwohl es bei einem bestimmten Testbeispiel erwartungsgemäß funktioniert, wenn dasselbe Testbeispiel mit unterschiedlicher syntaktischer Struktur ausgedrückt wird, in seiner Vorhersage scheitert.

Auszüge aus dem Leben...

- oktober 2019: https://www.theguardian.com/technology/2019/oct/16/automated-messages-welfare-australia-system

In Australien entscheidet ein automatisiertes System über eingestellte Zahlungen an Empfänger:innen von Sozialleistungen und versendet jede Woche rund 50.000 entsprechende Benachrichtigungen. Luke Henriques-Gomes, Australien-Korrespondent bei The Guardian, berichtet über die teils prekären Situationen, in denen die Betroffenen dadurch landen würden. Häufig genügten geringste Versäumnisse, etwa die Nichtteilnahme an einem von der Arbeitsagentur kurzfristig festgelegten Termin, für einen Zahlungsstopp. Problematisch seien laut Henriques-Gomes nicht nur das aggressive Regelwerk des Systems und die Tatsache, dass menschliches Personal bei den Behörden immer weniger Einfluss auf Entscheidungen habe, sondern auch, dass den Betroffenen Ansprechpartner:innen fehlten – gerade dann, wenn eine algorithmische Entscheidung sich als falsch herausstellt (Fehlentscheidungen der Software sorgten sorgten schon vor zwei Jahren für Aufsehen).

Gemäß der Recherche des Guardian seien zwei Gruppen in besonderem Maße negativ von dem System betroffen: Obdachlose und Alleinerziehende.

Da errechnet der Computer laut Medienberichten bereits heute, wer nicht produktiv genug ist, und verwarnt und entlässt automatisiert. Der Vorgesetzte muss nur noch gegenzeichnen, wie das Portal mit diesem Dokument belegt. Laut dem Bericht würden jedes Jahr zahlreiche Mitarbeiter aufgrund mangelnder Effizienz entlassen, wobei die Überwachung und Auswahl mithilfe eines automatisierten Tools erfolge. Einige Mitarbeiter gaben an, dass sie deshalb bereits so weit wie möglich auf Toilettenpausen verzichteten.

Wie das US-Magazins "The Verge" berichtet, setzt der US-Onlineversandhändler einen Algorithmus ein, um die Arbeit seiner Mitarbeiter zu kontrollieren und auszuwerten. Ist die Leistung nicht zufriedenstellend, kann das System die Mitarbeiter sogar feuern. Kündigungen und Abmahnungen verschickt die KI teilweise automatisiert – und ohne vorherige Zustimmung eines Vorgesetzten.

- Oktober 2018: https://www.heise.de/newsticker/meldung/Amazon-KI-zur-Bewerbungspruefung-benachteiligte-Frauen-4189356.html

- Amazon: KI zur Bewerbungsprüfung benachteiligte Frauen - Ein automatisches Bewertungssystem von Bewerbungen bei Amazon wurde größtenteils eingestampft, nachdem der US-Konzern mitbekommen hatte, dass die KI Frauen systematisch benachteiligte. Das geht aus einem Bericht der Nachrichtenagentur Reuters hervor. Demnach war seit 2014 intern ein Algorithmus entwickelt worden, der unter mehreren Bewerbungstexten automatisch jene der vielversprechendsten Bewerber herausfiltern sollte.