XAI / Language Models: Unterschied zwischen den Versionen

Aus exmediawiki

C.heck (Diskussion | Beiträge) |

Mattis (Diskussion | Beiträge) huggingface |

||

| (7 dazwischenliegende Versionen von 2 Benutzern werden nicht angezeigt) | |||

| Zeile 149: | Zeile 149: | ||

* »on the road« by AI: https://medium.com/artists-and-machine-intelligence/ai-poetry-hits-the-road-eb685dfc1544 | * »on the road« by AI: https://medium.com/artists-and-machine-intelligence/ai-poetry-hits-the-road-eb685dfc1544 | ||

---- | |||

====Autoencoder==== | ====Autoencoder==== | ||

https://www.wired.co.uk/article/google-artificial-intelligence-poetry | https://www.wired.co.uk/article/google-artificial-intelligence-poetry | ||

---- | |||

====LSTM+Autoencoder==== | ====LSTM+Autoencoder==== | ||

* https://github.com/keras-team/keras/issues/1401 | * https://github.com/keras-team/keras/issues/1401 | ||

* https://www.dlology.com/blog/how-to-do-unsupervised-clustering-with-keras/ | * https://www.dlology.com/blog/how-to-do-unsupervised-clustering-with-keras/ | ||

---- | |||

====GAN==== | ====GAN==== | ||

https://arxiv.org/abs/1705.10929 | https://arxiv.org/abs/1705.10929 | ||

---- | |||

====Newer techniques==== | ====Newer techniques==== | ||

=====transformer-based language models===== | ====='''transformer-based language models'''===== | ||

======'''OpenAI's gpt-2'''====== | ======'''OpenAI's gpt-2'''====== | ||

* https://openai.com/blog/better-language-models/ | * https://openai.com/blog/better-language-models/ | ||

** Improving Language Understanding by Generative Pre-Training https://s3-us-west-2.amazonaws.com/openai-assets/research-covers/language-unsupervised/language_understanding_paper.pdf | ** Improving Language Understanding by Generative Pre-Training https://s3-us-west-2.amazonaws.com/openai-assets/research-covers/language-unsupervised/language_understanding_paper.pdf | ||

** https://github.com/openai/gpt-2 | ** https://github.com/openai/gpt-2 | ||

======'''Weiterentwicklung / Implementierung'''====== | |||

https://huggingface.co/ | |||

Writer: https://transformer.huggingface.co/doc/distil-gpt2 | |||

Diskussion (old): | Diskussion (old): | ||

| Zeile 172: | Zeile 177: | ||

How to Build...(old): | How to Build...(old): | ||

* https://blog.floydhub.com/gpt2/ | * https://blog.floydhub.com/gpt2/ | ||

---- | |||

======BERT====== | ======'''BERT'''====== | ||

bidirectional encoder representations from Transformers https://arxiv.org/abs/1810.04805 | bidirectional encoder representations from Transformers https://arxiv.org/abs/1810.04805 | ||

---- | |||

=====LSTM-based language models===== | ====='''LSTM-based language models'''===== | ||

======ELMO====== | ======'''ELMO'''====== | ||

Deep contextualized word representations https://arxiv.org/abs/1802.05365 < uses bidirectional LSTM | Deep contextualized word representations https://arxiv.org/abs/1802.05365 < uses bidirectional LSTM | ||

---- | |||

======GRU (Gated Recurrent Unit)====== | ======'''GRU''' (Gated Recurrent Unit)====== | ||

it uses so-called, update gate and reset gate https://arxiv.org/abs/1406.1078 | it uses so-called, update gate and reset gate https://arxiv.org/abs/1406.1078 | ||

* https://towardsdatascience.com/understanding-gru-networks-2ef37df6c9be | * https://towardsdatascience.com/understanding-gru-networks-2ef37df6c9be | ||

| Zeile 187: | Zeile 193: | ||

===datenbanken=== | ===datenbanken=== | ||

muß upgedated werden!! | |||

deutsch: | deutsch: | ||

* https://de.wikipedia.org/wiki/GermaNet | * https://de.wikipedia.org/wiki/GermaNet | ||

| Zeile 198: | Zeile 206: | ||

---- | ---- | ||

===chatbots=== | ===chatbots=== | ||

'''siehe [[Chatbots|Chatbot-exMediaWiki-Seite]]''' | |||

---- | ---- | ||

===Toolkits/Librarys=== | ===Toolkits/Librarys=== | ||

* Natural Language Toolkit: http://www.nltk.org/ | * Natural Language Toolkit: http://www.nltk.org/ | ||

Aktuelle Version vom 14. Februar 2020, 08:14 Uhr

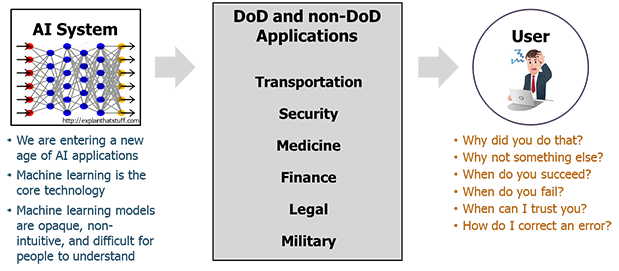

ETHICS

- https://www.economist.com/science-and-technology/2018/02/15/computer-programs-recognise-white-men-better-than-black-women

- https://books.google.de/books?id=rLsyDwAAQBAJ&pg=PA95&redir_esc=y#v=onepage&q&f=false

- https://books.google.de/books?id=_H1K3vojDFQC&pg=PA762&redir_esc=y#v=onepage&q&f=false

- https://neil.fraser.name/writing/tank/

- https://www.wired.com/story/why-ai-is-still-waiting-for-its-ethics-transplant/

- AI Now Report: https://medium.com/@AINowInstitute/the-10-top-recommendations-for-the-ai-field-in-2017-b3253624a7

- https://bdtechtalks.com/2018/03/26/racist-sexist-ai-deep-learning-algorithms/

- https://www.spiegel.de/netzwelt/web/facebook-foerdert-die-ki-forschung-an-der-tu-muenchen-gastbeitrag-a-1250796.html#ref=rss

XAI

- https://de.m.wikipedia.org/wiki/Explainable_Artificial_Intelligence

- https://netzpolitik.org/2018/enquete-kommission-kuenstliche-intelligenz-sachverstaendige-und-abgeordnete-klaeren-grundbegriffe/

- https://www.ayasdi.com/blog/artificial-intelligence/trust-challenge-explainable-ai-not-enough/

- https://www.bons.ai/blog/explainable-artificial-intelligence-using-model-induction

- https://en.m.wikipedia.org/wiki/Right_to_explanation

- https://bdtechtalks.com/2018/09/25/explainable-interpretable-ai/

- RISE: https://bdtechtalks.com/2018/10/15/kate-saenko-explainable-ai-deep-learning-rise/

- DARPA: https://www.darpa.mil/program/explainable-artificial-intelligence

Bedeutung:

- https://de.m.wikipedia.org/wiki/Bedeutung_(Sprachphilosophie)

- https://de.m.wikipedia.org/wiki/Philosophie_des_Geistes

- https://de.m.wikipedia.org/wiki/Mustererkennung

Code to work on...

Lime: Explaining the predictions of any machine learning classifier

This project is about explaining what machine learning classifiers (or models) are doing. At the moment, we support explaining individual predictions for text classifiers or classifiers that act on tables (numpy arrays of numerical or categorical data) or images, with a package called lime (short for local interpretable model-agnostic explanations).

Argument Mining AM

Argumentext

rgumenText ist ein Validierungsprojekt des Ubiquitous Knowledge Processing (UKP) Labs an der Technischen Universität Darmstadt. Unser Ziel ist es, die aktuellsten Forschungsergebnisse in den Bereichen Argument Mining und Textanalyse für die industrielle Anwendung zu validieren und Produkte zu entwickeln, die das Potenzial unstrukturierter Daten freisetzen. Von einer zuvor für die Identifikation von Argumentstrukturen in Studentenaufsätzen entwickelten Joint-Modeling Methode (Stab und Gurevych 2017) ausgehend, entwickeln wir robuste „end-to-end“ Ansätze um Argumente aus webbasierten Datensammlungen zu extrahieren.

Durch Sprachadaption erweitern wir unsere aktuellen Methoden auf andere Sprachen wie Deutsch und evaluieren deren Performanz auf diversen Themen und Textarten. Die daraus resultierende Software kann in Echtzeit Argumente aus dynamischen Textquellen wie Nachrichtenströmen oder sozialen Netzwerken gewinnen, um dann daraus eine für den Nutzer verständliche Zusammenfassung zu erstellen.

Demo

XAI durch Sprachrationalisierung

- https://de.wikipedia.org/wiki/Rationalismus

- Baumgarten ... << Rationalismus und Ästhetik

- sinnliche Erfahrung v.s. Wissen a priori << wo stehen wir hier mit der ästhetischen Erfahrung?

- https://www.kubi-online.de/artikel/aesthetische-erfahrung

- Baumgarten ... << Rationalismus und Ästhetik

- Rationalization: A Neural Machine Translation Approach to Generating Natural Language Explanations

Youtube Video:

- Interpretable Machine Learning Using LIME Framework - Kasia Kulma (PhD), Data Scientist, Aviva

LANGUAGE

Konstruierte, bzw. Künstliche Sprachen

- https://www.fatum-magazin.de/ausgaben/dialog/praefrontal/kunstsprachen.html

- https://de.wikipedia.org/wiki/Konstruierte_Sprache

- http://deacademic.com/dic.nsf/dewiki/441004

esoterische (KI) Programmiersprachen

- https://esolangs.org/w/index.php?search=neural&title=Special%3ASearch&profile=default&fulltext=1

- esoterische programmiersprachen http://kryptografie.de/kryptografie/chiffre/index-sprachen.htm

- Forscher suchen eigene Programmiersprache: https://t3n.de/news/machine-learning-facebooks-ki-chef-sucht-sprache-1144900/

Computer (und) Literatur

- p0es1s: http://www.p0es1s.net/p0es1s/intro_d.htm

- stochastische Texte: https://auer.netzliteratur.net/0_lutz/lutz_original.html

- Netzliteratur (Projekte): https://netzliteratur.net/netzliteratur_projekte_a.php

Florian Cramer:

- https://www.netzliteratur.net/cramer/poetische_kalkuele_und_phantasmen.pdf

- https://www.netzliteratur.net/cramer/wordsmadefleshpdf.pdf

KI und Literatur

AI-Poetry Examples...

- https://hackernoon.com/i-tried-my-hand-at-deep-learning-and-made-some-poetry-along-the-way-2e350c33376f

- https://www.japandigest.de/aktuelles/technologie-roboter/kunstliche-intelligenz-schreibt-haiku/

- https://bgr.com/2018/08/08/poetry-ai-bot-shakespeare-human-research/

- https://www.konstantext.de/index.php/item/sonnenblicke-auf-der-flucht-wenn-kuenstliche-intelligenz-ein-gedicht-schreibt

(KI-generierte) Krypto

- https://motherboard.vice.com/de/article/8q8wkv/google-ki-entwickelt-verschluesselung-die-selbst-google-nicht-versteht

- http://kryptografie.de/kryptografie/index.htm

NLU / NLI

- https://www.informatik-aktuell.de/betrieb/kuenstliche-intelligenz/natural-language-understanding-nlu.html

- https://en.wikipedia.org/wiki/Natural-language_understanding

NLP

Speech recognition

- https://de.wikipedia.org/wiki/Spracherkennung

- https://www.golem.de/news/deep-speech-0-2-mozillas-spracherkennung-wird-kleiner-und-kann-echtzeit-1809-136645.html

NLG

https://byteacademy.co/blog/overview-NLG

- https://de.wikipedia.org/wiki/Textgenerierung

- http://www.thealit.de/lab/serialitaet/teil/nieberle/nieberle.html

- Google: https://motherboard.vice.com/de/article/mg7md8/eine-kuenstliche-intelligenz-von-google-hat-gerade-seine-eigene-sprache-erfunden

- veröffentlichtes Paper: https://arxiv.org/pdf/1611.04558v1.pdf

- FB Bots: https://code.fb.com/ml-applications/deal-or-no-deal-training-ai-bots-to-negotiate/

(un-)supervised techniques

LSTM

LSTM+RNN

- https://adventuresinmachinelearning.com/recurrent-neural-networks-lstm-tutorial-tensorflow/

- Jürgen Schmidhuber: http://people.idsia.ch/~juergen/rnn.html

- https://codeburst.io/recurrent-neural-network-4ca9fd4f242

- »on the road« by AI: https://medium.com/artists-and-machine-intelligence/ai-poetry-hits-the-road-eb685dfc1544

Autoencoder

https://www.wired.co.uk/article/google-artificial-intelligence-poetry

LSTM+Autoencoder

- https://github.com/keras-team/keras/issues/1401

- https://www.dlology.com/blog/how-to-do-unsupervised-clustering-with-keras/

GAN

https://arxiv.org/abs/1705.10929

Newer techniques

transformer-based language models

OpenAI's gpt-2

- https://openai.com/blog/better-language-models/

- Improving Language Understanding by Generative Pre-Training https://s3-us-west-2.amazonaws.com/openai-assets/research-covers/language-unsupervised/language_understanding_paper.pdf

- https://github.com/openai/gpt-2

Weiterentwicklung / Implementierung

https://huggingface.co/ Writer: https://transformer.huggingface.co/doc/distil-gpt2

Diskussion (old):

How to Build...(old):

BERT

bidirectional encoder representations from Transformers https://arxiv.org/abs/1810.04805

LSTM-based language models

ELMO

Deep contextualized word representations https://arxiv.org/abs/1802.05365 < uses bidirectional LSTM

GRU (Gated Recurrent Unit)

it uses so-called, update gate and reset gate https://arxiv.org/abs/1406.1078

datenbanken

muß upgedated werden!!

deutsch:

englisch:

E2E NLG Challenge:

chatbots

siehe Chatbot-exMediaWiki-Seite

Toolkits/Librarys

- Natural Language Toolkit: http://www.nltk.org/

- Poetry Generator: https://github.com/schollz/poetry-generator

tryouts:

- https://machinelearningmastery.com/text-generation-lstm-recurrent-neural-networks-python-keras/

- https://remicnrd.github.io/Natural-language-generation/

- https://github.com/shashank-bhatt-07/Natural-Language-Generation-using-LSTM-Keras

REPRODUKTIVE KI

https://www.sir-apfelot.de/kuenstliche-intelligenz-erschafft-neue-ki-systeme-10436/