Word embeddings

Aus exmediawiki

Version vom 13. November 2019, 14:10 Uhr von C.heck (Diskussion | Beiträge) (→Auszüge aus dem Leben...)

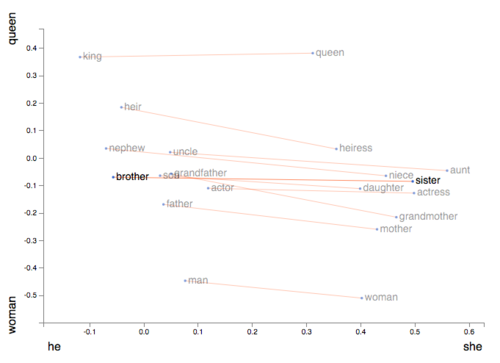

Der Sammelbegriff für eine Reihe von Sprachmodellierungs- und Feature-Learning-Techniken in der natürlichen Sprachverarbeitung (NLP), bei denen Wörter oder Phrasen aus dem Vokabular auf Vektoren mit reellen Zahlen abgebildet werden:

- ein Vektor, der die Struktur des Wortes in Bezug auf Morphologie widerspiegelt ( Anreichern von Wortvektoren mit Unterwortinformationen ) * eine Wortkontextdarstellung ( word2vec Parameter Learning Explained )

- eine globale Korpusstatistik ( GloVe: Globale Vektoren für Wortdarstellung )

- eine Worthierarchie in Bezug auf die WordNet-Terminologie ( Poincaré-Einbettungen für das Lernen hierarchischer Darstellungen )

- eine Beziehung zwischen einer Reihe von Dokumenten und den Begriffen, die sie enthalten ( latente semantische Indizierung )

- usw. ...

Warum brauchen wir embeddings?

für "meaningful" (Bedutungs-) Repräesentationen eines Wortes in einem Vectorenraum << word vectors

generell gilt, je mehr Dimensionen ein Vektor besitzt, desto mehr Bedeutung können wir in diesen hineinlegen < problem computational grenze

Inhaltsverzeichnis

Traditionelle Worteinbettungen

Bag of Words (BOW)

term frequency–inverse document frequency (TFIDF)

Neuronale Einbettungen / pretrained word embeddings

Word2Vec-Algorithmus

Der beliebteste Algorithmus für die Berechnung von Einbettungen. Er besteht im Wesentlichen aus einem mini neuronalen Netzwerk, das versucht, ein Sprachmodell zu lernen.

Mikolov, Chen, Corrado & Dean (2013): Efficient Estimation of Word Representations in Vector Space

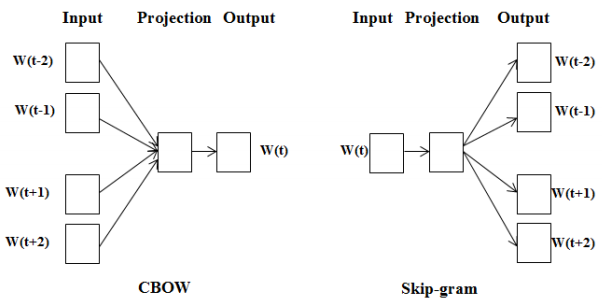

CBOW & Skip-Gram

Continuous Bag-Of-Words (CBOW)

Hier geht es darum, ein Netzwerk zu schaffen, das versucht, das Wort in der Mitte bei einigen umgebenden Wörtern vorherzusagen:

[W[-3], W[-2], W[-1], W[1], W[2], W[3]] => W[0]

Skip-Gram

Skip-Gram ist das Gegenteil von CBOW, es versucht, die umgebenden Wörter vorherzusagen, die das Wort in der Mitte enthält:

W[0] =>[W[-3], W[-2], W[-1], W[1], W[2], W[3]]]

Die berechneten Netzwerkgewichte sind eigentlich die Wort Embeddings

Word2Vec mit Gensim

Wir benutzen in unserem Seminar Gensim. Diese Bibliothek beinhaltet u.a. eine Implementation des Word2Vec Models

GloVe

FastText

Neuronale NLP Architekturen

nächste Woche

Deep Feed Forward Network

1D CNN

RNN/LSTM

ELMo & BERT

pitfalls of modern state of the art NLP systems.

Obwohl neuronales NLP zu vielen Durchbrüchen geführt hat, wie in den vorherigen Beiträgen zu sehen, gibt es immer noch viele Mängel, die von Modellen auf dem neuesten Stand der Technik mit vorab trainierten Worteinbettungen und Aufmerksamkeitsmechanismen gezeigt wurden. Diese Fehler in der neuronalen NLP haben gefährliche Auswirkungen auf Produktionssysteme, die nur wenig oder gar keinen Spielraum für Ungenauigkeit und Unvorhersehbarkeit bieten.