Diskussion:Künstliche Intelligenzen

Aus exmediawiki

- Topics

- wie gehabt

-

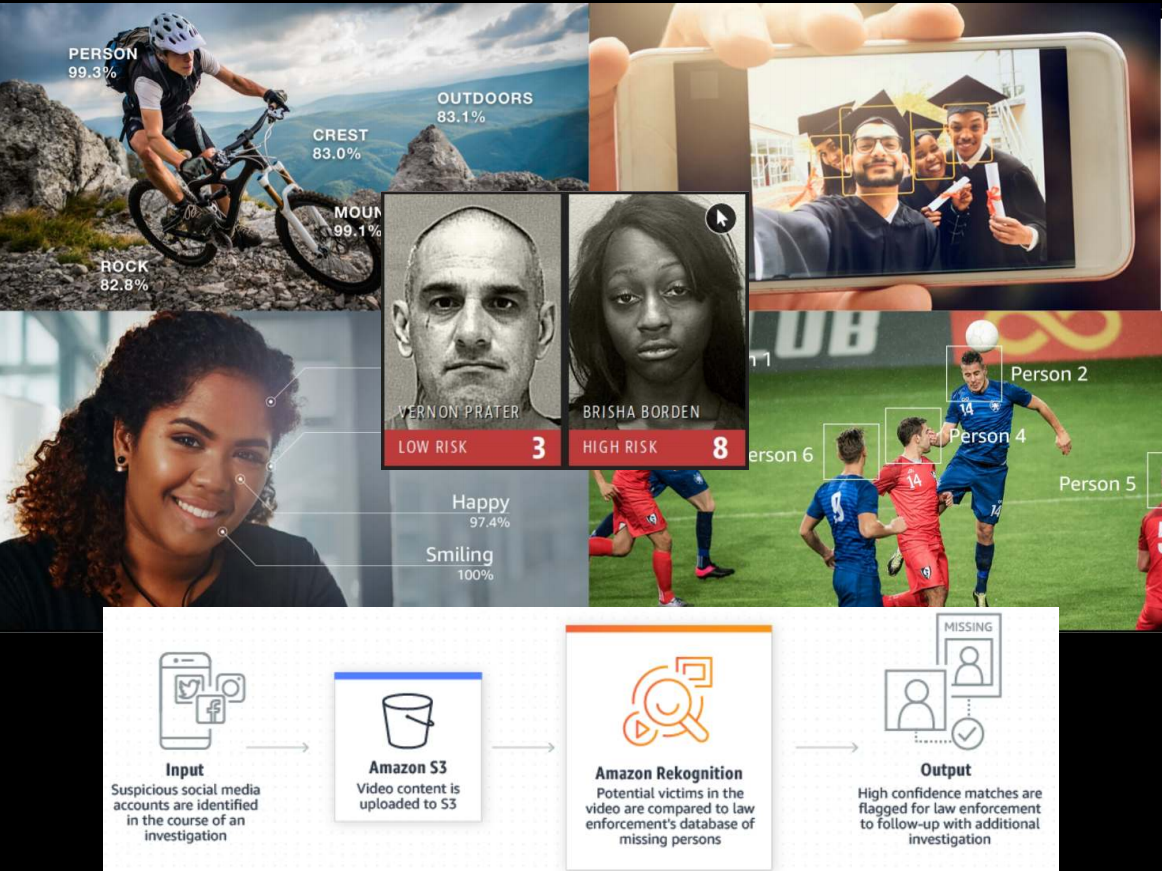

- Computer Vision

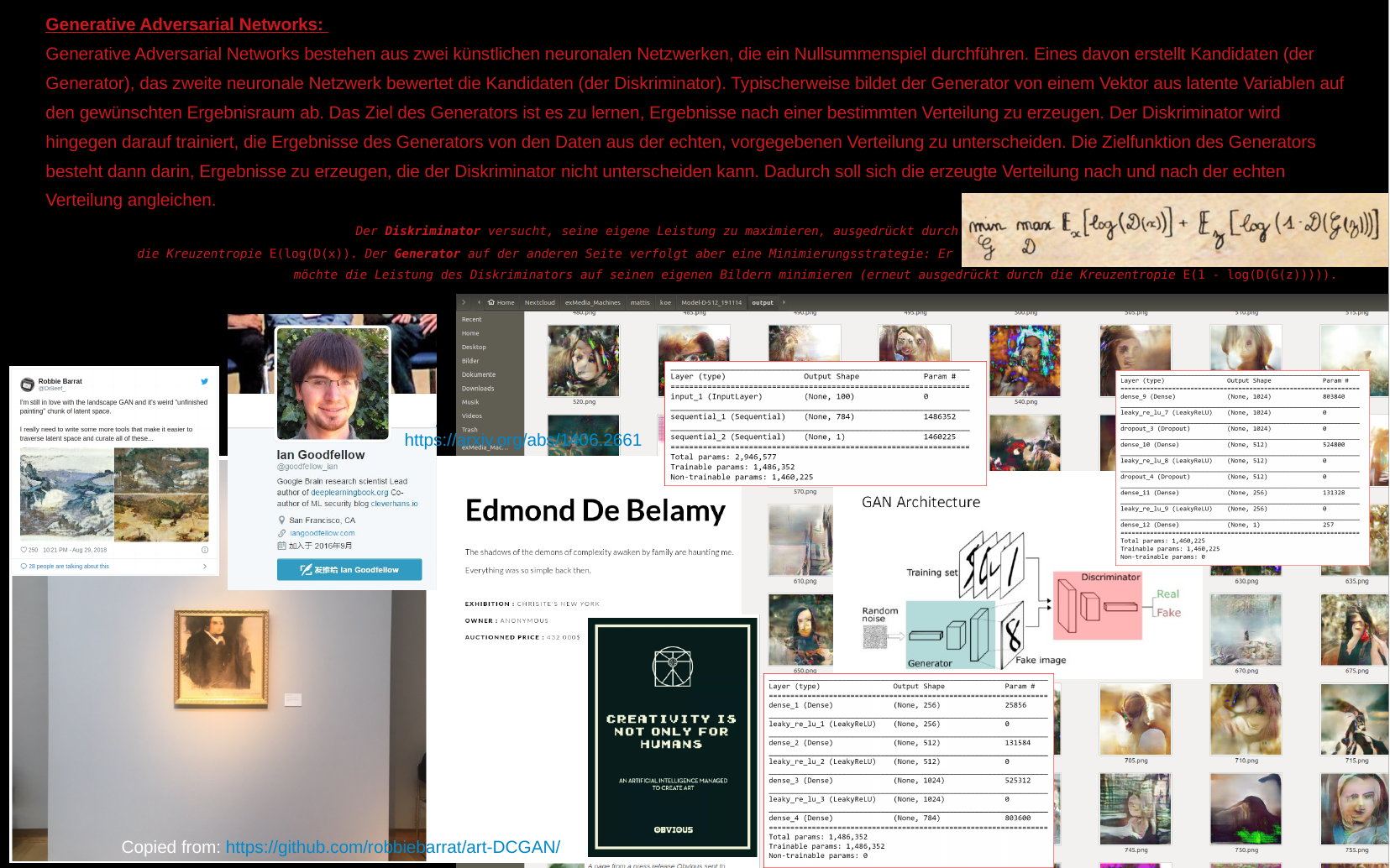

- GAN

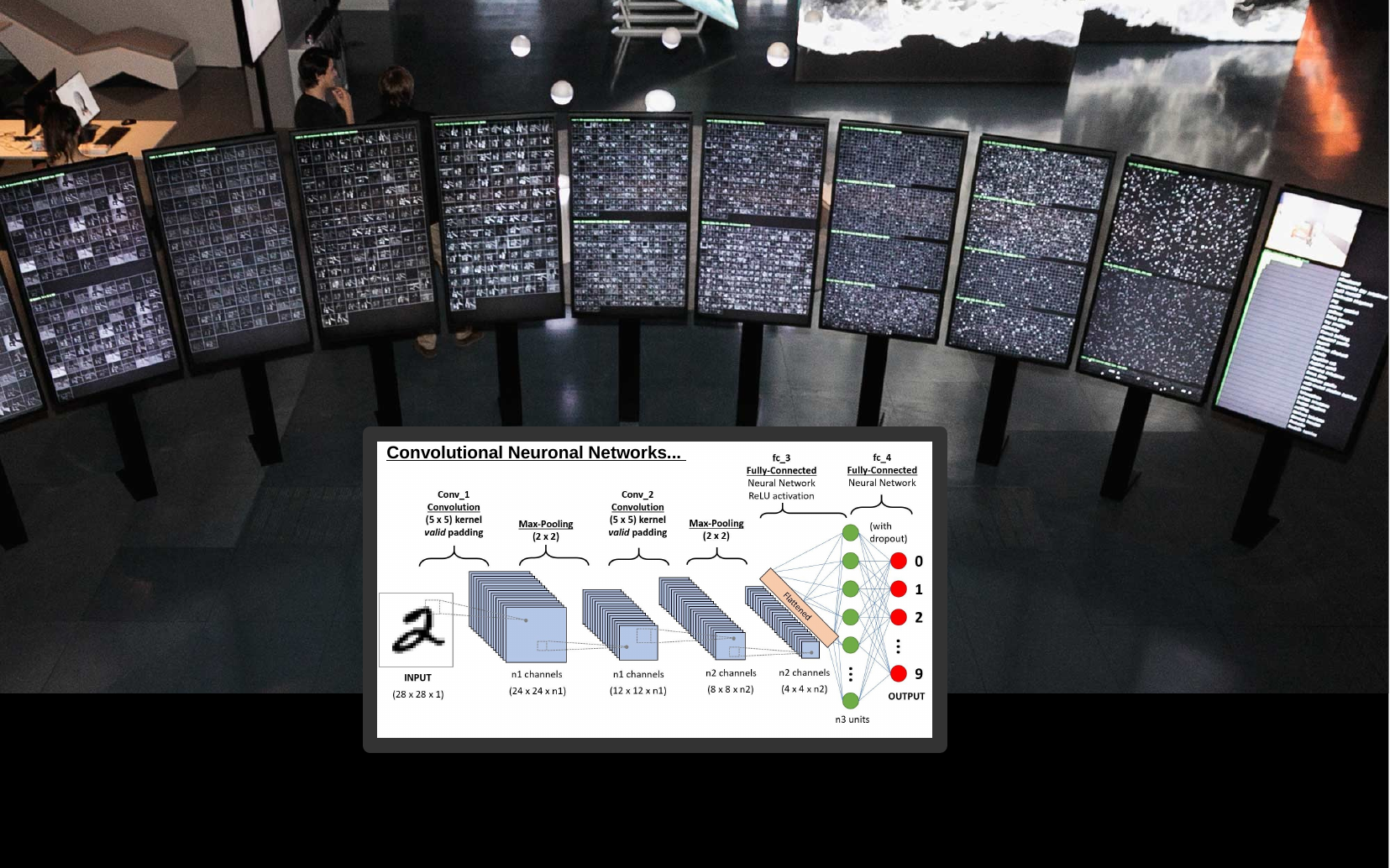

- CNN

- etc.

- NLP

- Computer Vision

- Publikationen

- Artikel

- Hausarbeiten

- Papers

- ?

- künstlerische Arbeiten

- Ausstellungen

- Lehre

- Seminare

- Gastvorträge

- Forschung

- Papers

- Experimente

- Code

@ Experimentelle Informatik

-

AI & Art -

AI & Society -

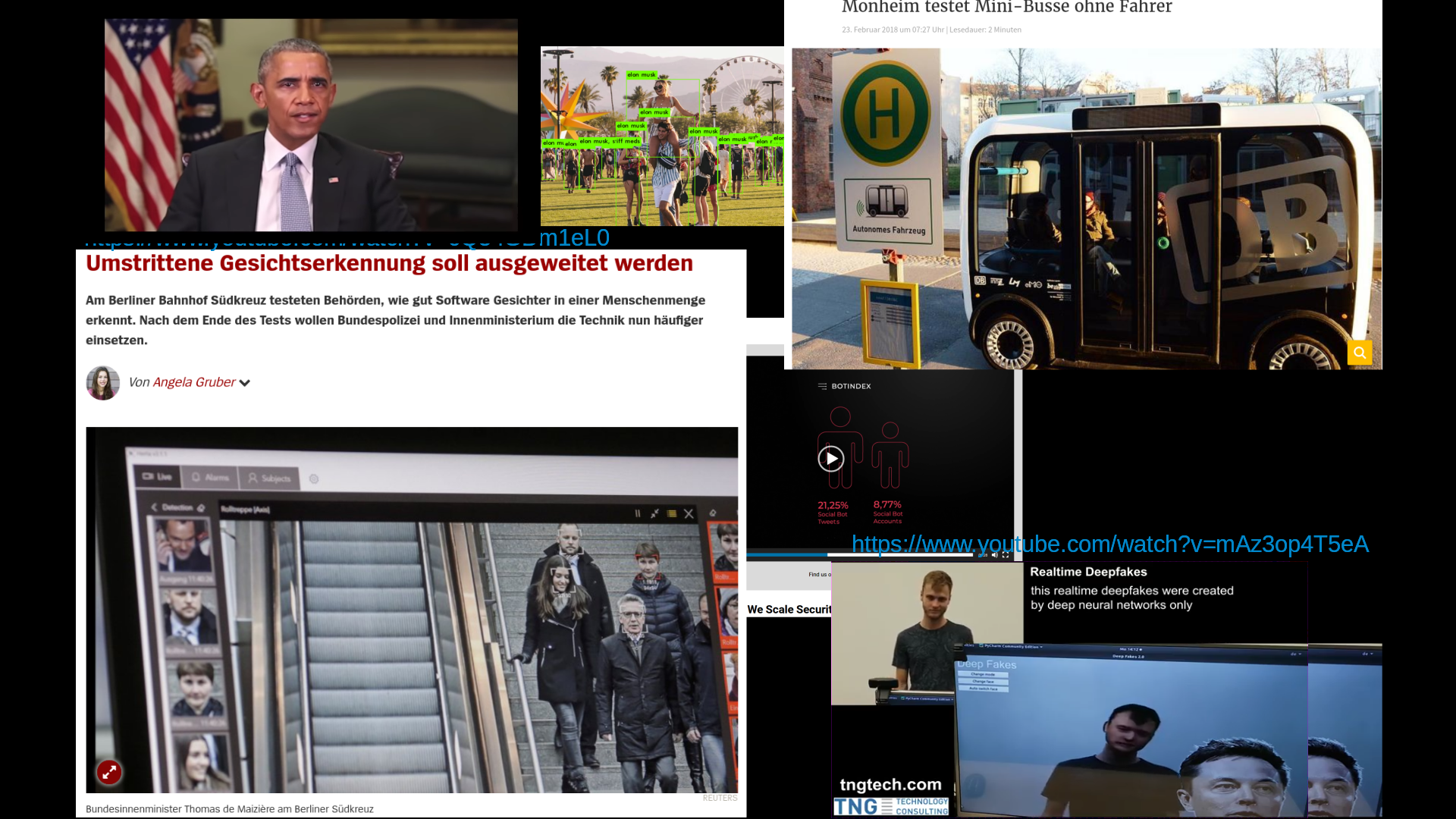

AI & security technology -

Convolutional Neuronal Networks @ ZKM -

Generative Adversarial Networks -

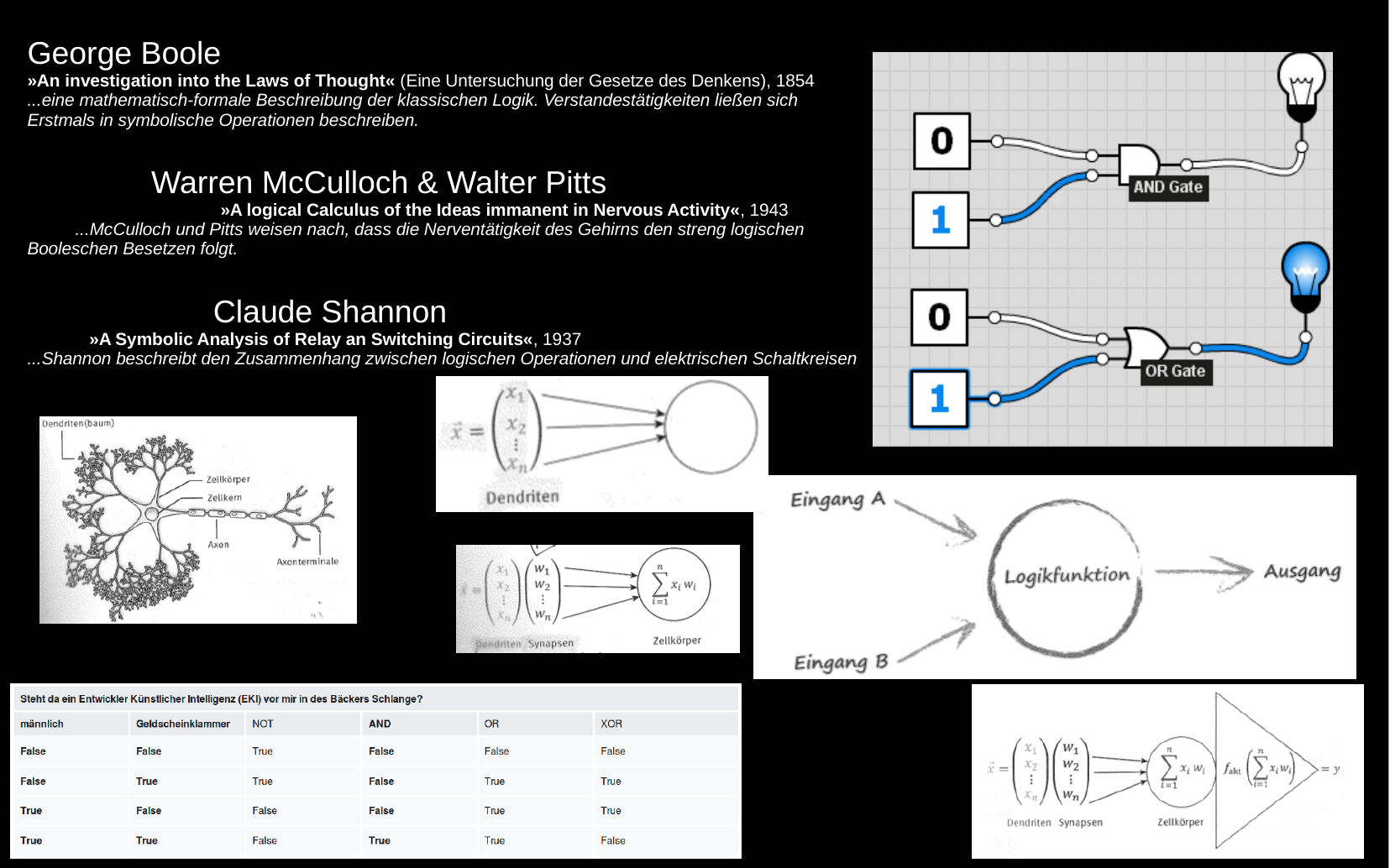

logics -

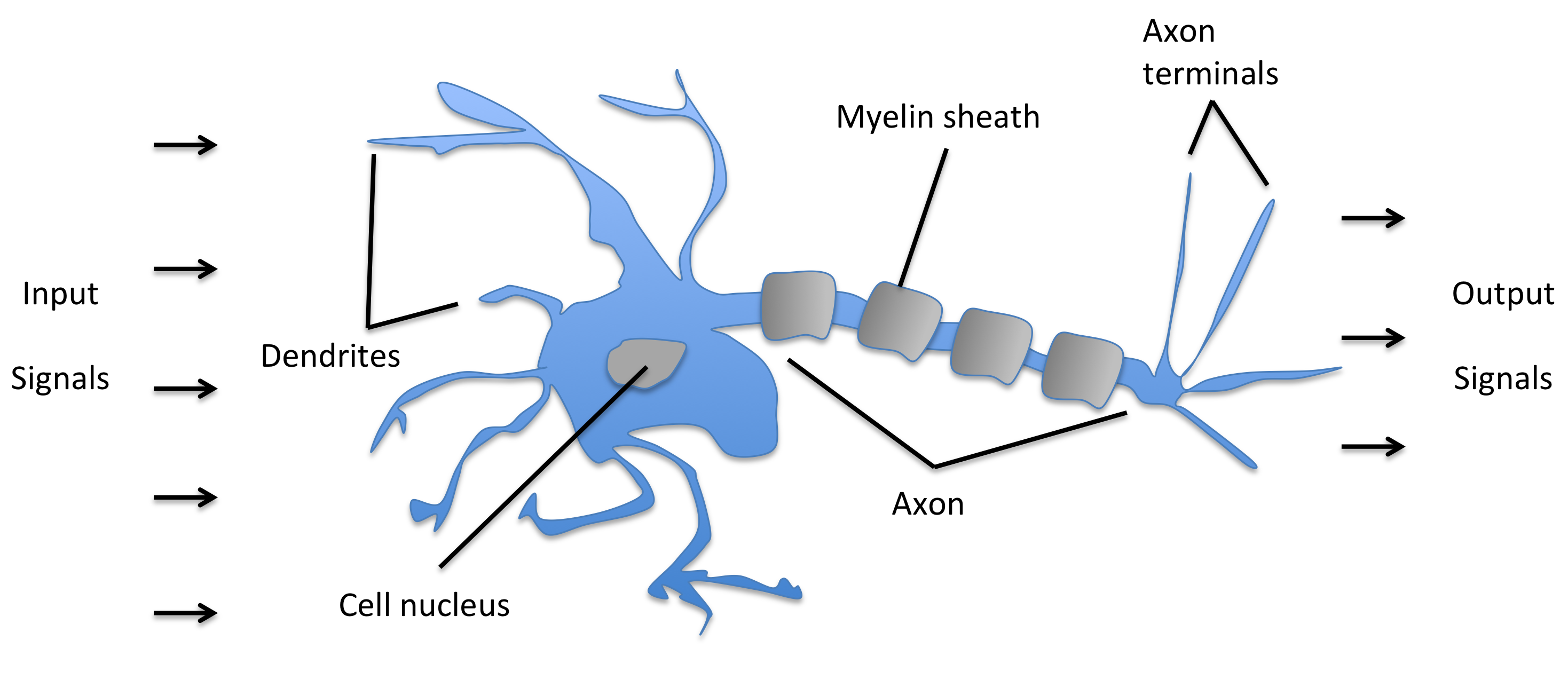

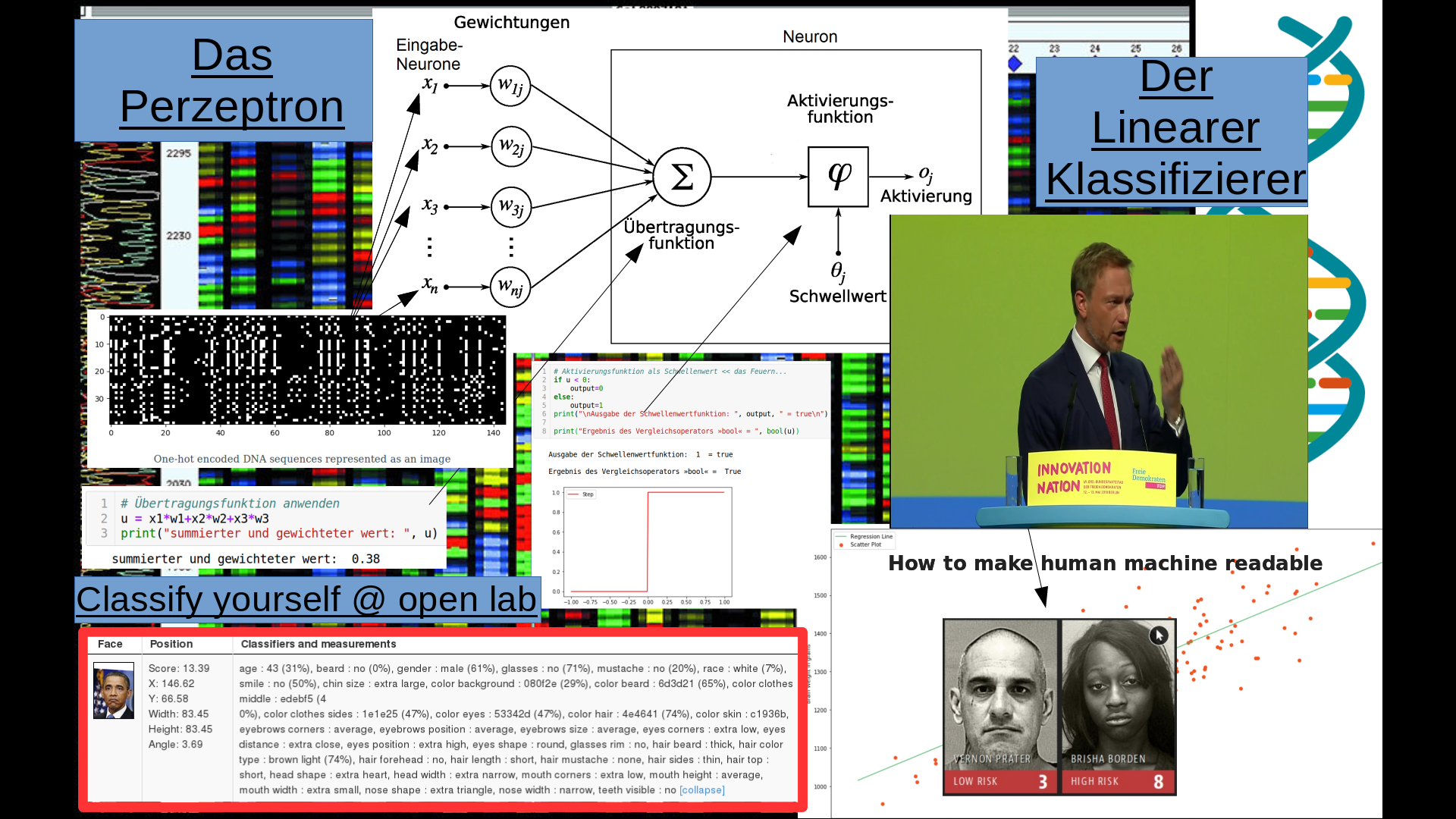

perceptrons -

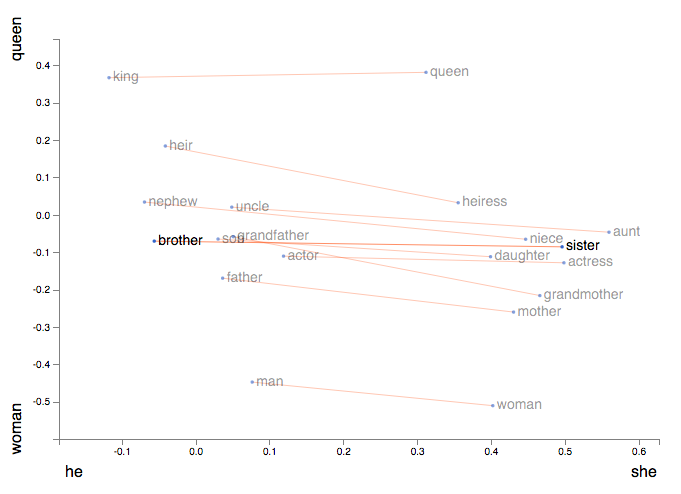

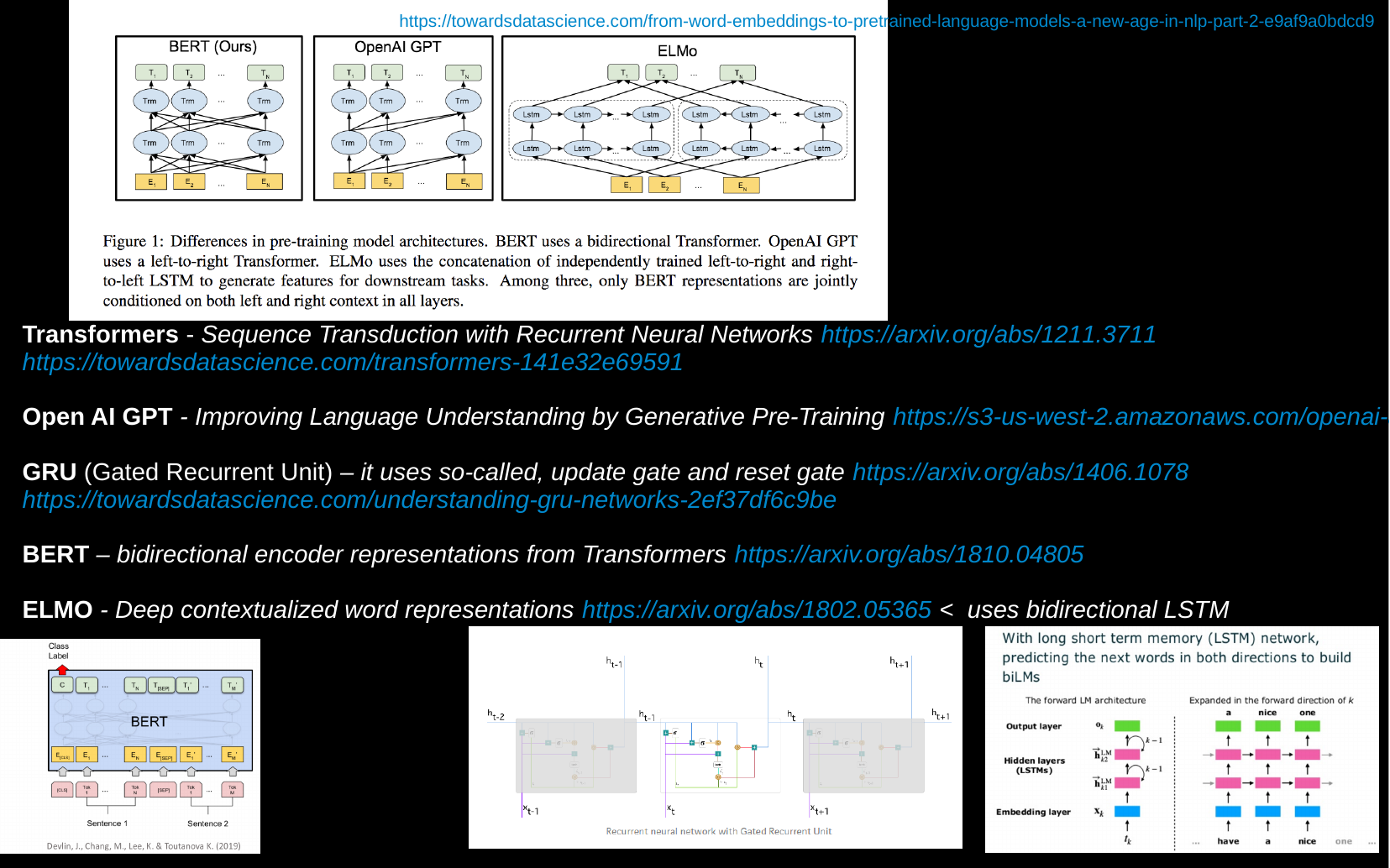

Transformers, ELMo & BERT -

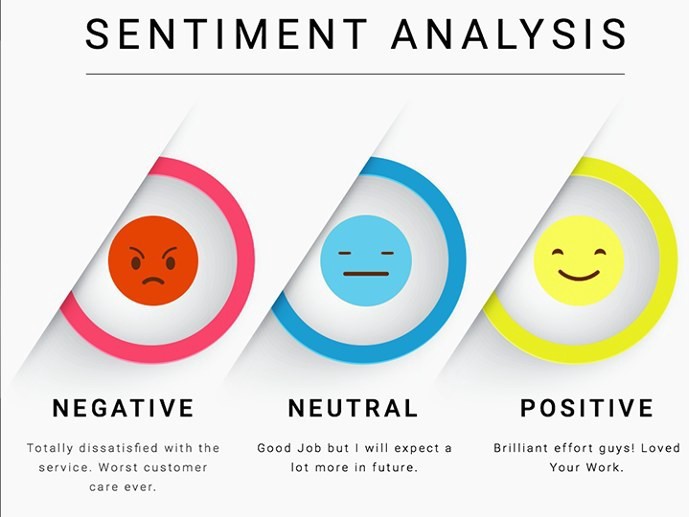

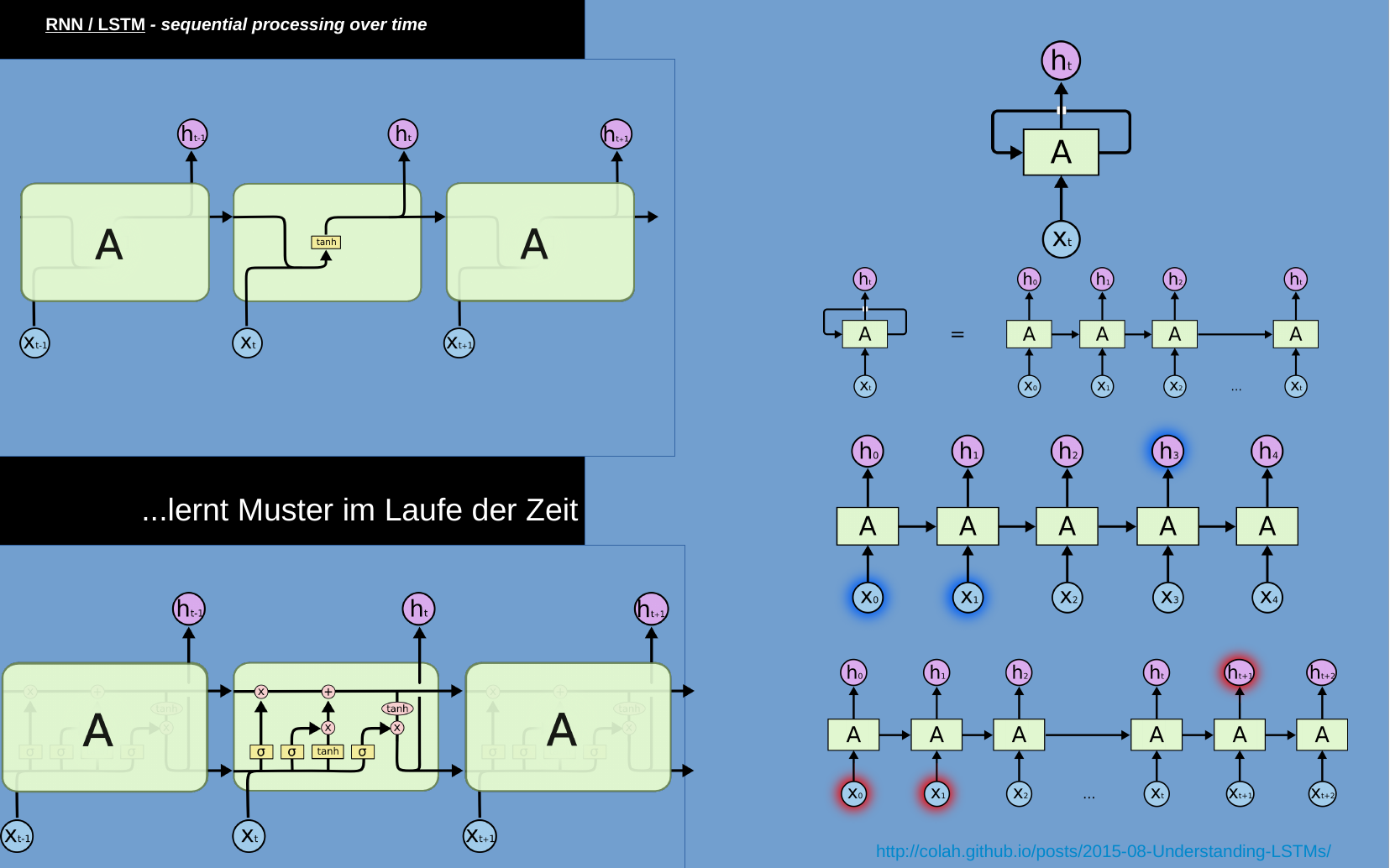

text classification in time -

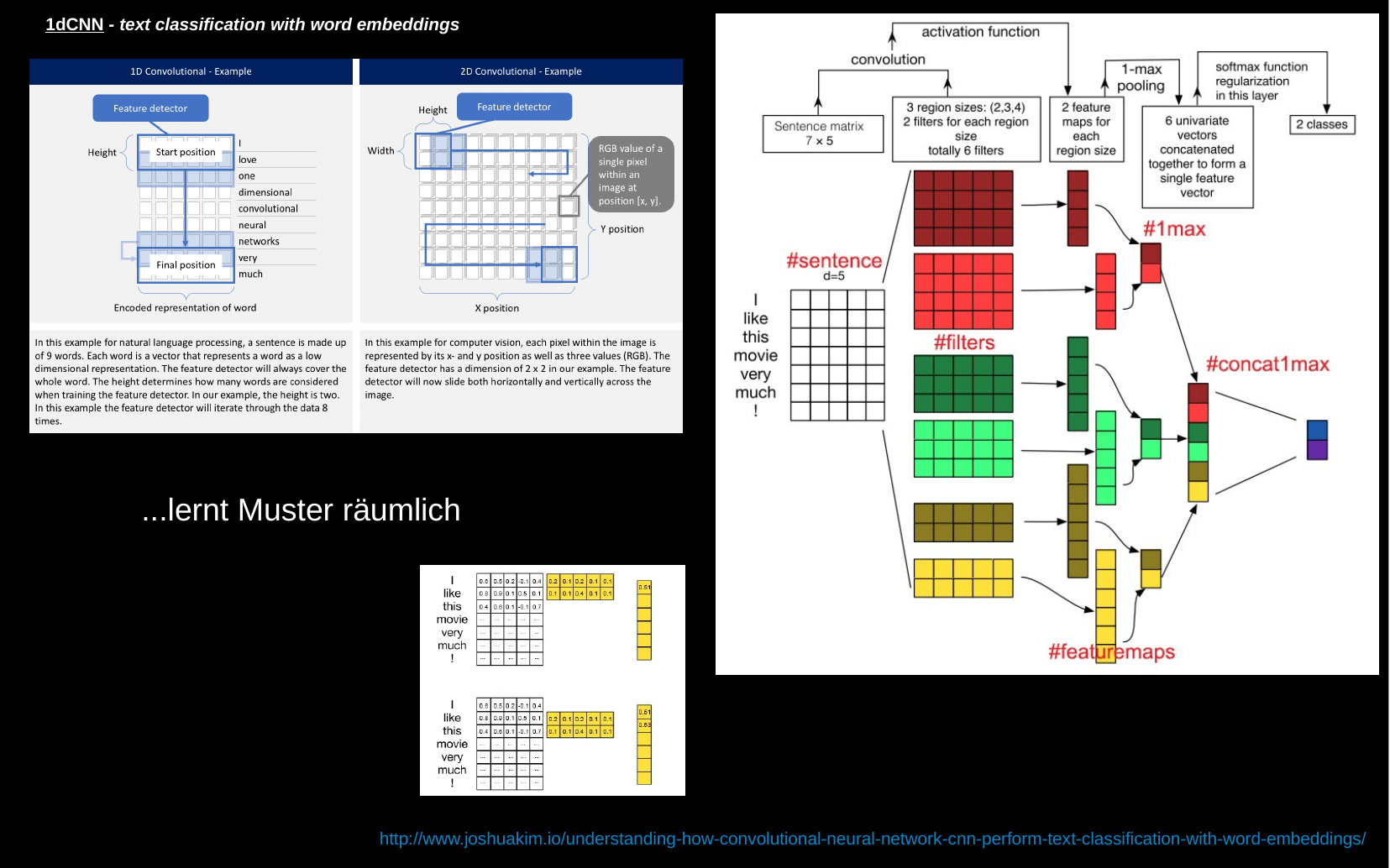

text classification in space

| Titel: | Future Minds – Kritik Künstlicher Intelligenzen |

|---|---|

| Kursleiter: | Georg Trogemann, Christian Heck |

| Seminarstyp: | Theorieseminar |

| Zeitraum: | WiSe 2019/20 |

| Veranstaltungsort: | Filzengraben 8 - 10, 0.2 Experimentelle Informatik |

| Seminarsbeschreibung: | siehe Seminarswikiseite |

| Titel: | Einführung in die Programmierung Künstlicher Intelligenzen |

|---|---|

| Kursleiter: | Georg Trogemann, Christian Heck |

| Seminarstyp: | Grundlagenseminar |

| Zeitraum: | WiSe 2019/20 |

| Veranstaltungsort: | Filzengraben 8 - 10, 0.2 Experimentelle Informatik |

| Seminarsbeschreibung: | siehe Seminarswikiseite |

| Titel: | Kunst & KI |

|---|---|

| Kursleiter: | Georg Trogemann |

| Seminarstyp: | Fachseminar |

| Zeitraum: | SoSe 2018/19 |

| Veranstaltungsort: | Filzengraben 8 - 10, 0.2 Experimentelle Informatik |

| Seminarsbeschreibung: | siehe Seminarswikiseite |

| Titel: | Einführung in die Programmierung künstlicher Intelligenzen |

|---|---|

| Kursleiter: | Georg Trogemann, Christian Heck |

| Seminarstyp: | Grundlagenseminar |

| Zeitraum: | WiSe 2018/19 |

| Veranstaltungsort: | Filzengraben 8 - 10, 0.2 Experimentelle Informatik |

| Seminarsbeschreibung: | siehe Seminarswikiseite |

AI & Warfare

Künstliche Intelligenzen werden als "Kriegstechnologie", -im allgemeinen Sinne verstanden als eine Technologie für den Einsatz zu konkreten Kampfhandlungen-, in erster Linie eingesetzt zur: Navigation z.B. KI-gesteuerter Drohnenschwärme, zur Zielerkennung- und identifikation, z.B. ARGUS-IS, zur Angriffsplanung- und ausführung z.B. (C4I, Command, Control, Computers, Communications and Information) und als Assistenzsysteme für Kampfpiloten, um aus großer Entfernung heraus Abschussentscheidungen zu treffen, oder auch um autonom zu navigieren.

Bei den Begrifflichkeiten des Dual Use, sowie des derzeit häufig verwendeten Begriffs der Sicherheitstechnologie betreten wir in unserer Zivilgesellschaft rechtliche und ethische Grenzzonen.

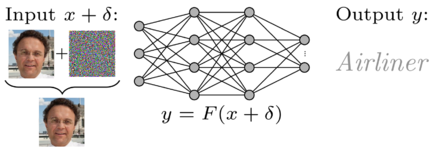

AI Hacking

Adversarial Attacks sind Modelle und Methoden mit denen z.B. Klassifikatoren für maschinelles Lernen gehackt werden können. Bekannte Beispiele aus der Forschung hierfür sind beispielsweise 3D-gedruckte Modelle einer Schildkröte, die als Gewehr klassifiziert wurden oder autonome Fahrzeuge, deren eingebettete Computer Vision Straßenschilder falsch einordneten. Auch Künstler wie z.B. Adam Harvey, Zach Blas & Jemina Wyman und Heather Dewey-Hagborg haben in ihren Projekten adversarial processes verwendet, um Gesichtserkennungssysteme zu untergraben und kritisch darauf zu reagieren.

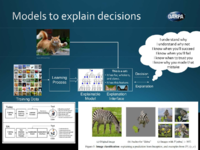

XAI

Explainable Artificial Intelligence, verfolgt das ausgesprochene Ziel "Third-Wave-KI-Systeme" zu ermöglichen. Systeme, in denen Maschinen den Kontext und die Umgebung, in der sie arbeiten „verstehen“ lernen sollen, um im Laufe der Zeit Erklärungsmodelle (Explainable Models) aufzubauen, die es ihnen ermöglichen, reale Phänomene zu charakterisieren.

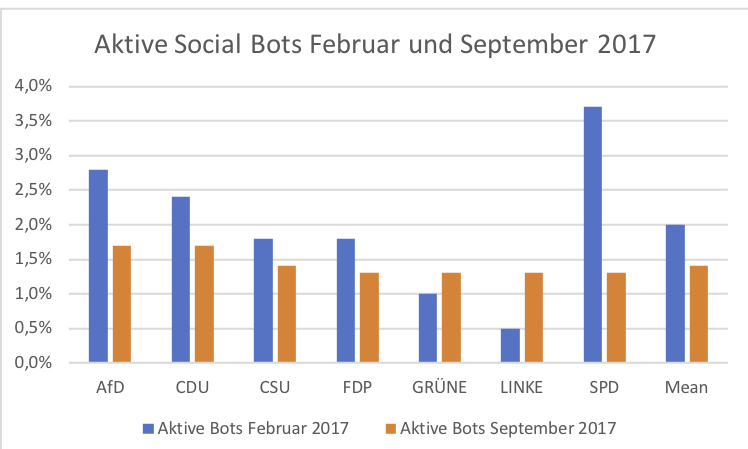

AI & Political Subversion

Anarchistic Decision Making ...

in arbeit...

- KünstlerInnen, Ausstellungen, Festivals, Open Calls etc.

- KI / Kunst- Genres

- Künstliche Neuronale Netze (Coding Links)

KI-Newsletter:

- KI-Newsletter_1 21.03.2019

- KI-Newsletter_2 02.05.2019

- KI-Newsletter_3 07.06.2019